Customer-managed VPC

重要的

此功能要求您的帳戶位於Databricks平台的E2版本Beplay体育安卓版本.所有新的Databricks帳戶和大多數現有帳戶現在都是E2。如果您不確定您擁有的帳戶類型,請與您的Databricks代表聯係。

重要的

這篇文章提到了這個術語數據平麵,是Databricks平台的計算層。Beplay体育安卓版本在本文的上下文中,數據平麵指的是AWS帳戶中的Classic數據平麵。相比之下,支持的Serverless數據平麵無服務器SQL倉庫(公開預覽)在Databricks AWS帳戶中運行。要了解更多,請參見Serverless計算.

概述

默認情況下,集群創建在單個AWS VPC(虛擬私有雲)中,由Databricks在您的AWS帳戶中創建和配置。您可以選擇在您自己的VPC中創建您的Databricks工作空間,該特性稱為customer-managed VPC.您可以使用客戶管理的VPC,對您的網絡配置進行更多的控製,以滿足您的組織可能需要的特定的雲安全和治理標準。

重要的

來配置要使用的工作區AWS PrivateLink(公共預覽)對於任何類型的連接,都要求您的工作空間使用客戶管理的VPC。

客戶管理VPC是一個很好的解決方案,滿足以下條件:

防止PaaS提供商在您自己的AWS帳戶中創建vpc的安全策略。

創建VPC的審批流程,由內部信息安全團隊或雲工程團隊對VPC進行詳細的配置和安全保護。

福利包括:

低特權級別:您對自己的AWS帳戶保持更多的控製。你不需要通過跨帳戶IAM角色授予Databricks像在Databricks管理的VPC中那樣多的權限。例如,創建vpc不需要權限。這種有限的權限集可以使您更容易獲得在平台堆棧中使用Databricks的批準。Beplay体育安卓版本

簡化的網絡運營:更好的網絡空間利用率。與默認的CIDR /16相比,可選地為工作空間配置更小的子網。並且不需要在其他解決方案中進行複雜的VPC對等配置。

整合vpc:多個Databricks工作空間可以共享一個數據平麵VPC,通常用於計費和實例管理。

限製對外聯係:默認情況下,數據平麵不限製Databricks Runtime worker的外發連接。對於配置為使用客戶管理的VPC的工作空間,您可以使用出口防火牆或代理設備將出站流量限製為允許的內部或外部數據源列表。

為了使用客戶管理的VPC,您需要在首次創建Databricks工作空間時指定VPC。不能將已創建了VPC的工作空間移動到客戶管理的VPC中。您可以通過更新工作空間的網絡配置對象,將已有的帶有客戶管理VPC的工作空間從一個VPC移動到另一個VPC中。看到更新一個工作區.

當需要在自己的VPC中部署工作空間時,需要:

VPC需求

為了承載Databricks工作空間,您的VPC需要滿足本節的要求。

VPC地區

工作區數據平麵vpc可以位於AWS區域中ap-northeast-1,ap-northeast-2,ap-south-1,ap-southeast-1,ap-southeast-2,ca-central-1,一來就,eu-west-2,eu-central-1,us-east-1,us-east-2,us-west-1,us-west-2.,不能使用VPCus-west-1如果你想用customer-managed鍵為加密。

VPC分級

一個VPC可以與一個AWS帳戶中的多個工作空間共享。然而,你不能在工作空間之間重用子網或安全組.請根據需要設置VPC和子網的大小。Databricks為每個節點分配兩個IP地址,一個用於管理通信,另一個用於Apache Spark應用程序。每個子網的實例總數等於可用IP地址數量的一半。學習更多的子網.

VPC IP地址範圍

Databricks不限製工作空間VPC的網絡掩碼,但每個工作空間子網之間必須有一個網絡掩碼/ 17而且/ 26.這意味著如果您的工作空間有兩個子網,並且兩個子網的掩碼都為/ 26,則工作區VPC的網絡掩碼為/ 25或更小。

重要的

如果您已經為VPC配置了從CIDR塊,請確保Databricks工作區的子網配置了相同的VPC CIDR塊。

DNS

VPC中需要開啟DNS主機名和DNS解析功能。

子網

數據庫必須至少有訪問權限每個工作區有兩個子網,每個子網位於不同的可用分區中。中的每個可用分區不能指定多個Databricks工作區子網創建網絡配置API調用.作為網絡設置的一部分,每個可用分區可以有多個子網,但是對於Databricks工作空間,每個可用分區隻能選擇一個子網。

Databricks為每個節點分配兩個IP地址,一個用於管理流量,另一個用於Spark應用程序。每個子網的實例總數等於可用IP地址數量的一半。

每個子網之間必須有一個子網掩碼/ 17而且/ 26.

重要的

為客戶管理VPC指定的子網隻能為一個Databricks工作空間使用。您不能與任何其他資源(包括其他Databricks工作區)共享這些子網。

額外的子網

重要的

使用安全集群連通性(2020年9月1日以後為默認)的工作空間,需要允許VPC向外訪問公網。

子網路由表

工作空間子網的路由表必須有四零(0.0.0.0/0)以適當的網絡設備為目標的通訊。如果工作空間使用安全集群連通性(這是2020年9月1日之後的新工作空間的默認設置),四零流量必須以NAT網關或您自己的托管NAT設備或代理設備為目標。

重要的

Databricks需要添加子網0.0.0.0/0到您的允許列表。要控製出口流量,請使用出口防火牆或代理設備來阻止大多數流量,但允許Databricks需要連接的url。看到配置防火牆和出站接入(可選).

這隻是一個基本的指導方針。您的配置要求可能不同。如有問題,請聯係您的Databricks代表。

安全組

Databricks必須能夠訪問至少一個AWS安全組,且不超過5個安全組。您可以重用現有的安全組,而不是創建新的安全組。

安全組必須遵循以下規則:

出口(出站):

允許所有TCP和UDP訪問工作空間安全組(用於內部流量)

允許TCP訪問

0.0.0.0/0這些端口:443:用於Databricks基礎設施、雲數據源和庫存儲庫

3306:用於轉移瘤

6666:使用時才需要PrivateLink

入口(入站):所有工作區都需要(這些可以是單獨的規則,也可以組合成一個):

當流量源使用同一個安全組時,允許所有端口使用TCP協議

當流量源使用同一個安全組時,允許所有端口使用UDP協議

Subnet-level網絡acl

子網級網絡acl不能禁止任何流量的進入或出。Databricks在創建工作區時驗證以下規則:

允許所有從源0.0.0.0/0出口:

允許所有流量進入工作空間VPC CIDR,用於內部流量

允許TCP訪問0.0.0.0/0的端口:

443:用於Databricks基礎設施、雲數據源和庫存儲庫

3306:用於轉移瘤

6666:使用時才需要PrivateLink

重要的

如果您配置了額外的允許或否認將Databricks所需的規則設置為最高優先級(最低的規則編號),以便它們具有優先級。

請注意

Databricks需要添加子網級的網絡acl0.0.0.0/0到您的允許列表。要控製出口流量,請使用出口防火牆或代理設備來阻止大多數流量,但允許Databricks需要連接的url。看到配置防火牆和出站接入(可選).

AWS PrivateLink支持

如果您計劃在該VPC的工作空間中啟用AWS PrivateLink:

在VPC中,需要同時開啟這兩種設置DNS主機名而且DNS解析.

評論文章使AWS PrivateLink參考如何為VPC端點多創建一個子網(推薦,不需要)和為VPC端點多創建一個安全組。

創建一個VPC

要創建vpc,您可以使用各種工具:

使用AWS Console時,創建、配置VPC及相關對象的基本指導如下。有關完整的說明,請參閱AWS文檔。

請注意

這些基本的指示可能並不適用於所有的組織。您的配置要求可能不同。本節不涉及配置nat、防火牆或其他網絡基礎設施的所有可能方法。如果您有疑問,請在繼續之前與您的Databricks代表聯係。

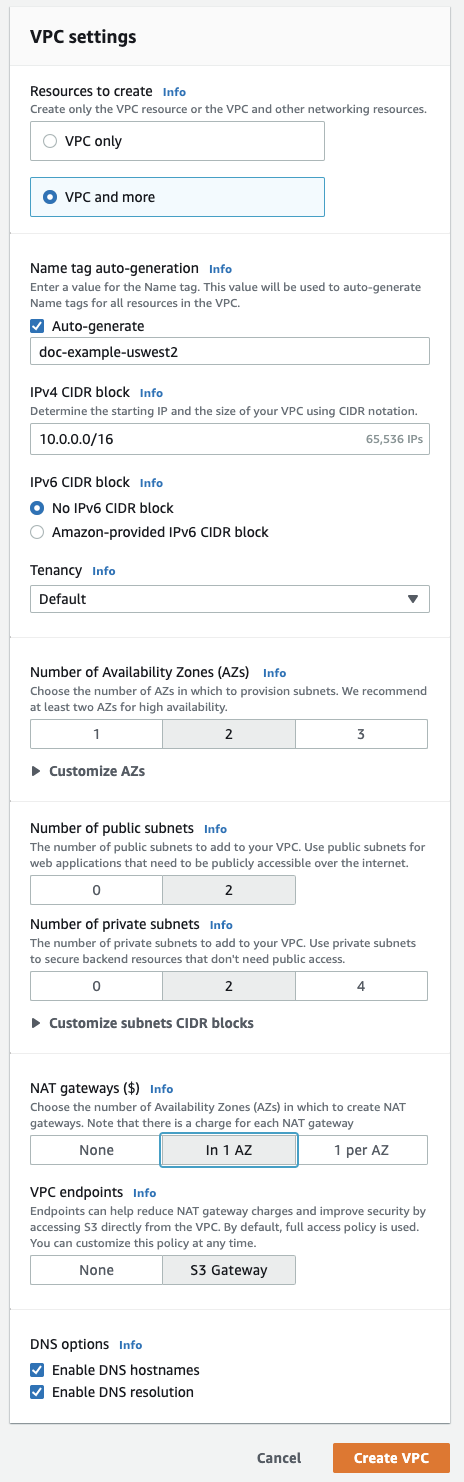

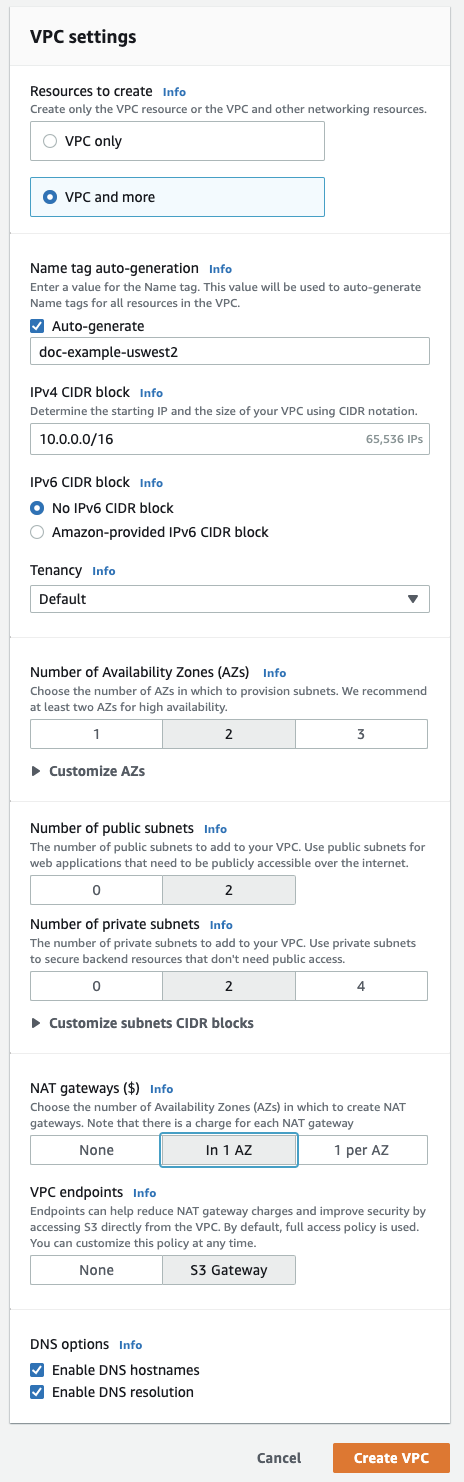

請參閱右上角的區域選擇器。如果需要,切換到工作區的區域。

在右上角,單擊橙色按鈕創建VPC.

點擊VPC,更.

在姓名標簽自動生成為您的工作區鍵入一個名稱。Databricks建議在名稱中包含地區。

“VPC地址範圍”可根據需要進行修改。

對於公網子網,單擊

2.Databricks工作空間並不直接使用這些子網,但是在此編輯器中啟用nat需要這些子網。對於私有子網,單擊

2為工作區子網的最小值。如果需要,您可以添加更多。您的Databricks工作空間至少需要兩個私有子網。如果需要調整大小,例如共享一個VPC和多個需要劃分子網的工作空間,請單擊自定義子網CIDR塊.

對於NAT網關,單擊1阿茲.

確保底部的以下字段都已啟用:使DNS主機名而且使DNS解析.

點擊創建VPC.

查看新創建的VPC時,可單擊左側導航中的,更新VPC的相關設置。為使查找相關對象更容易,在根據VPC過濾字段,選擇新的VPC。

點擊子網也就是AWS所說的私人標記為1和2的子網,您將使用它們來配置您的主工作區子網。修改子網VPC需求.

如果為使用PrivateLink創建了額外的私有子網,請按照中指定的配置私有子網3使AWS PrivateLink.

點擊安全組,修改安全組安全組.

如果要使用後端PrivateLink連通性,請按照本節的PrivateLink文章中指定的那樣,創建一個附加的具有入站和出站規則的安全組步驟1:配置AWS網絡對象.

點擊網絡acl,修改網絡aclSubnet-level網絡acl.

選擇是否執行本文後麵指定的可選配置。

在Databricks中注冊VPC,創建網絡配置使用帳戶控製台或通過使用Account API.

配置防火牆和出站接入(可選)

如果你正在使用安全集群連接(截至2020年9月1日的默認值),使用出口防火牆或代理設備來阻止大多數流量,但允許Databricks需要連接的url:

如果防火牆或代理設備與Databricks工作VPC在同一個VPC中,需要對流量進行路由,並配置允許以下連接。

當防火牆或代理設備在其他VPC或企業網絡中時,需要配置路由

0.0.0.0/0連接到該VPC或網絡,並配置代理設備允許如下連接。

重要的

Databricks強烈建議在出口基礎設施中將目的地指定為域名,而不是IP地址。

允許以下外發連接:

磚的web應用程序:必須的。也用於對工作區的REST API調用。

數據庫安全集群連接(SCC)中繼:如果您的工作空間使用安全集群連通性(這是帳戶中的工作空間的默認值),則必須E2版本平台Beplay体育安卓版本截至2020年9月1日。

AWS S3全局URL: Databricks訪問S3根桶所需。

AWS S3區域URL:可選的。但是,您可能會使用其他S3桶,在這種情況下還必須允許S3區域端點。Databricks建議創建S3 VPC端點,以便流量通過AWS網絡骨幹網上的私有隧道。

AWS STS全球網址:必須的。

AWS STS區域URL:由於預期切換到區域端點而需要。

AWS Kinesis區域URL:用於捕獲管理和監控軟件所需的日誌。對於大多數區域,使用區域URL。然而,對於vpc

us-west-1例如,VPC終端不會在今天生效,您必須確保允許使用Kinesis URLus-west-2(不us-west-1).Databricks建議您創建一個Kinesis VPC端點,以便流量通過AWS網絡骨幹網上的私有隧道。表metastore RDS區域URL(按數據平麵區域):如果你的Databricks工作空間使用默認的Hive metastore,它總是與你的數據平麵區域在同一區域,則必須。這意味著它可能與控製平麵處於相同的地理位置但不同的區域。而不是使用默認的Hive metastore,你可以選擇實現您自己的表metastore實例,在這種情況下,您負責其網絡路由。

所需數據平麵地址

允許從以下地址連接,為您的地區:

端點 |

VPC地區 |

地址 |

港口 |

|---|---|---|---|

Webapp |

|

tokyo.cloud.m.eheci.com |

443 |

|

seoul.cloud.m.eheci.com |

443 |

|

|

mumbai.cloud.m.eheci.com |

443 |

|

|

singapore.cloud.m.eheci.com |

443 |

|

|

sydney.cloud.m.eheci.com |

443 |

|

|

canada.cloud.m.eheci.com |

443 |

|

|

frankfurt.cloud.m.eheci.com |

443 |

|

|

ireland.cloud.m.eheci.com |

443 |

|

|

london.cloud.m.eheci.com |

443 |

|

|

nvirginia.cloud.m.eheci.com |

443 |

|

|

ohio.cloud.m.eheci.com |

443 |

|

|

oregon.cloud.m.eheci.com |

443 |

|

|

oregon.cloud.m.eheci.com |

443 |

|

鱗狀細胞癌繼電器 |

|

tunnel.ap東北- 1. cloud.m.eheci.com |

443 |

|

tunnel.ap東北- 2. cloud.m.eheci.com |

443 |

|

|

tunnel.ap -南- 1. - cloud.m.eheci.com |

443 |

|

|

tunnel.ap東南- 1. cloud.m.eheci.com |

443 |

|

|

tunnel.ap東南- 2. cloud.m.eheci.com |

443 |

|

|

tunnel.ca中央- 1. cloud.m.eheci.com |

443 |

|

|

tunnel.eu中央- 1. cloud.m.eheci.com |

443 |

|

|

tunnel.eu -西方- 1. cloud.m.eheci.com |

443 |

|

|

tunnel.eu -西方- 2. cloud.m.eheci.com |

443 |

|

|

tunnel.us -東- 1. - cloud.m.eheci.com |

443 |

|

|

tunnel.us -東- 2. - cloud.m.eheci.com |

443 |

|

|

tunnel.cloud.m.eheci.com |

443 |

|

|

tunnel.cloud.m.eheci.com |

443 |

|

S3全球對根鬥 |

所有 |

s3.amazonaws.com |

443 |

S3區域其他桶:建議使用VPC終端 |

所有 |

s3。<區域名稱> .amazonaws.com |

443 |

STS全球 |

所有 |

sts.amazonaws.com |

443 |

運動:推薦使用VPC終端 |

大部分地區 |

運動。<區域名稱> .amazonaws.com |

443 |

|

kinesis.us -西方- 2. amazonaws.com |

443 |

|

RDS(如果使用內置轉移瘤) |

|

mddx5a4bpbpm05.cfrfsun7mryq.ap東北- 1. rds.amazonaws.com |

3306 |

|

md1915a81ruxky5.cfomhrbro6gt.ap東北- 2. rds.amazonaws.com |

3306 |

|

|

mdjanpojt83v6j.c5jml0fhgver.ap -南- 1. - rds.amazonaws.com |

3306 |

|

|

md1n4trqmokgnhr.csnrqwqko4ho.ap東南- 1. rds.amazonaws.com |

3306 |

|

|

mdnrak3rme5y1c.c5f38tyb1fdu.ap東南- 2. rds.amazonaws.com |

3306 |

|

|

md1w81rjeh9i4n5.co1tih5pqdrl.ca中央- 1. rds.amazonaws.com |

3306 |

|

|

mdv2llxgl8lou0.ceptxxgorjrc.eu中央- 1. rds.amazonaws.com |

3306 |

|

|

md15cf9e1wmjgny.cxg30ia2wqgj.eu -西方- 1. rds.amazonaws.com |

3306 |

|

|

mdio2468d9025m.c6fvhwk6cqca.eu -西方- 2. rds.amazonaws.com |

3306 |

|

|

mdb7sywh50xhpr.chkweekm4xjq.us -東- 1. - rds.amazonaws.com |

3306 |

|

|

md7wf1g369xf22.cluz8hwxjhb6.us -東- 2. - rds.amazonaws.com |

3306 |

|

|

mdzsbtnvk0rnce.c13weuwubexq.us -西方- 1. rds.amazonaws.com |

3306 |

|

|

mdpartyyphlhsp.caj77bnxuhme.us -西方- 2. rds.amazonaws.com |

3306 |

|

Databricks控製平麵基礎設施 |

|

35.72.28.0/28 |

443 |

|

3.38.156.176/28 |

443 |

|

|

65.0.37.64/28 |

443 |

|

|

13.214.1.96/28 |

443 |

|

|

3.26.4.0/28 |

443 |

|

|

3.96.84.208/28 |

443 |

|

|

3.250.244.112/28 |

443 |

|

|

18.134.65.240/28 |

443 |

|

|

18.159.44.32/28 |

443 |

|

|

3.237.73.224/28 |

443 |

|

|

3.128.237.208/28 |

443 |

|

|

44.234.192.32/28 |

443 |

配置區域端點(可選)

當使用客戶管理VPC時(可選)安全集群連接(截至2020年9月1日為默認值),您可能更傾向於配置您的VPC隻使用區域VPC端點與AWS服務連接,與AWS全局端點相比,連接更直接,成本更低。Databricks的工作空間和客戶管理的VPC必須訪問的AWS服務有四種:STS、S3、Kinesis和RDS。

隻有使用默認的Databricks metastore時,才需要在VPC中連接RDS服務。雖然RDS沒有VPC端點,但用戶可以配置自己的外部metastore,而不使用默認的Databricks的metastore。實現外部轉移瘤蜂巢metastore或AWS膠.

對於其他三種業務,您可以創建VPC網關或接口端點,以便來自集群的相關區域內流量可以通過安全的AWS骨幹網而不是公網傳輸:

S3:創建一個VPC網關端點可以直接從您的Databricks集群子網訪問。這導致區域內所有S3桶的工作空間流量都使用端點路由。要訪問任何跨區域桶,打開對S3全局URL的訪問

s3.amazonaws.com在出口設備或路由中0.0.0.0/0連接到AWS的互聯網網關。使用DBFS保險絲啟用區域端點時:

您必須在要設置的集群配置中設置一個環境變量

AWS_REGION = < aws-region-code >.例如,如果您的工作空間部署在N. Virginia區域,則設置AWS_REGION = us-east-1.要對所有集群強製執行,請使用集群政策.

STS:創建一個VPC接口端點直接從您的Databricks集群子網訪問。您可以在您的工作區子網中創建這個端點。Databricks建議使用與工作VPC相同的安全組。此配置導致到STS的工作空間通信量使用端點路由。

運動:創建一個VPC接口端點直接從您的Databricks集群子網訪問。您可以在您的工作區子網中創建這個端點。Databricks建議使用與工作VPC相同的安全組。此配置導致到Kinesis的工作空間流量使用端點路由。此規則的唯一例外是AWS區域中的工作空間

us-west-1這是不正確的,因為在這種情況下,目標運動流是跨區域的us-west-2.

解決區域端點

當VPC的端點不能正常工作時,如數據源不可訪問、流量繞過等,可以通過以下兩種方式:

添加環境變量

AWS_REGION在集群配置中,並將其設置為您的AWS區域。若要為所有集群啟用它,請使用集群政策.您可能已經配置了這個環境變量來使用DBFS FUSE。添加所需的Apache Spark配置:

要麼在每個源筆記本中:

%scalasc.hadoopConfiguration.集(“fs.s3a.endpoint”,“https://s3 <地區> .amazonaws.com”。)sc.hadoopConfiguration.集(“fs.s3a.stsAssumeRole.stsEndpoint”,“https://sts <地區> .amazonaws.com”。)

%pythonsc._jsc.hadoopConfiguration().集(“fs.s3a.endpoint”,“https://s3 <地區> .amazonaws.com”。)sc._jsc.hadoopConfiguration().集(“fs.s3a.stsAssumeRole.stsEndpoint”,“https://sts <地區> .amazonaws.com”。)

或在Apache Spark配置中:

火花.hadoop.fs.s3a.端點https://s3.<地區>。amazonaws.com火花.hadoop.fs.s3a.stsAssumeRole.stsEndpointhttps://sts.<地區>。amazonaws.com

要為所有集群設置這些值,請將這些值配置為您的集群政策.

使用實例概要訪問S3(可選)

訪問S3掛載實例配置文件,設置Spark的如下配置:

要麼在每個源筆記本中:

%scalasc.hadoopConfiguration.集(“fs.s3a.endpoint”,“https://s3 <地區> .amazonaws.com”。)sc.hadoopConfiguration.集(“fs.s3a.stsAssumeRole.stsEndpoint”,“https://sts <地區> .amazonaws.com”。)

%pythonsc._jsc.hadoopConfiguration().集(“fs.s3a.endpoint”,“https://s3 <地區> .amazonaws.com”。)sc._jsc.hadoopConfiguration().集(“fs.s3a.stsAssumeRole.stsEndpoint”,“https://sts <地區> .amazonaws.com”。)

或在Apache Spark配置中:

火花.hadoop.fs.s3a.端點https://s3.<地區>。amazonaws.com火花.hadoop.fs.s3a.stsAssumeRole.stsEndpointhttps://sts.<地區>。amazonaws.com

要為所有集群設置這些值,請將這些值配置為您的集群政策.

警告

對於S3服務,在筆記本或集群級別應用附加的區域端點配置是有限製的。值得注意的是,跨區域S3訪問被阻止,即使在出口防火牆或代理中允許全局S3 URL。如果您的Databricks部署可能需要跨區域S3訪問,那麼不要在筆記本或集群級別應用Spark配置,這一點很重要。

限製S3桶的訪問(可選)

對S3的大多數讀取和寫入在數據平麵中是自包含的。但有些管理操作來源於控製平麵,由Databricks進行管理。當需要將S3桶的訪問限製在指定源IP地址的集合時,可以創建S3桶策略。在桶策略中,需要將IP地址包含在aws: SourceIp列表。當使用VPC Endpoint時,可通過添加到策略的方式允許訪問aws: sourceVpce.

有關S3桶策略的更多信息,請參見限製對特定IP地址的訪問在Amazon S3文檔中。工作例子桶政策也包括在本主題中。

桶策略要求

你的桶策略必須滿足這些要求,以確保你的集群正確啟動,並且你可以連接到它們:

您必須允許從區域的控製平麵NAT IP地址.

需要允許數據平麵VPC的訪問,具體方式如下:

(推薦)配置網關型VPC EndpointCustomer-managed VPC把它加到

aws: sourceVpce到桶策略,或者將數據平麵NAT IP地址添加到

aws: SourceIp列表。

當使用Amazon S3的端點策略,你的保單必須包括:

你的工作空間根存儲桶.

所需的區域的工件、日誌和共享數據集桶.

避免從公司網絡內部失去連接, Databricks建議始終允許至少一個已知和信任的IP地址訪問,例如您的企業VPN的公共IP地址。這是因為Deny條件甚至適用於AWS控製台。

需要的ip和存儲桶

該表包含了使用S3桶策略和VPC Endpoint策略限製訪問工作空間的S3桶時所需的信息。

地區 |

控製平麵NAT IP |

構件存儲桶 |

日誌存儲桶 |

共享數據集水桶 |

|---|---|---|---|---|

|

18.177.16.95/32 |

|

|

|

|

54.180.50.119/32 |

|

|

|

|

13.232.248.161/32 |

|

|

|

|

13.213.212.4/32 |

|

|

|

|

13.237.96.217/32 |

|

|

|

|

35.183.59.105/32 |

|

|

|

|

18.159.32.64/32 |

|

|

|

|

46.137.47.49/32 |

|

|

|

|

3.10.112.150/32 |

|

|

|

|

54.156.226.103/32 |

|

|

|

|

18.221.200.169/32 |

|

|

|

|

52.27.216.188/32 |

|

|

|

|

52.27.216.188/32 |

|

|

|

例子桶政策

這些示例使用占位符文本指明在哪裏指定推薦的IP地址和所需的存儲桶。檢查需求確保您的集群正確啟動,並且您可以連接到它們。

限製對Databricks的控製平麵、數據平麵和受信任ip的訪問:

S3桶策略通過設置“禁止”條件,有選擇地允許來自控製平麵、NAT網關和企業VPN IP地址的訪問。將占位符文本替換為您環境的值。可以向策略中添加任意數量的IP地址。為您想要保護的S3桶創建一個策略。

重要的

如果使用“VPC終端”,此策略不完整。看到限製對

{“席德”:“IPAllow”,“效應”:“否認”,“校長”:“*”,“行動”:“s3: *”,“資源”:[“攻擊:aws: s3::: < s3 bucket >”,“攻擊:aws: s3::: < s3 bucket > / *”),“條件”:{“NotIpAddress”:{“aws: SourceIp”:[“< CONTROL-PLANE-NAT-IP >”,“< DATA-PLANE-NAT-IP >”,“< CORPORATE-VPN-IP >”]}}}

限製對Databricks控製平麵、VPC端點和信任ip的訪問:

當使用VPC Endpoint訪問S3時,需要在策略中添加第二個條件。該條件允許您的VPC Endpoint通過添加到aws: sourceVpce列表。

該桶有選擇地允許VPC終端、控製平麵和指定的企業VPN IP地址訪問。

使用“VPC端點”時,可以使用“VPC端點”策略代替S3桶策略。VPCE策略必須允許訪問您的根S3桶和所需的區域的工件、日誌和共享數據集桶.你可以了解VPC端點策略在AWS文檔中。

將占位符文本替換為您環境的值。

{“席德”:“IPAllow”,“效應”:“否認”,“校長”:“*”,“行動”:“s3: *”,“資源”:[“攻擊:aws: s3::: < s3 bucket >”,“攻擊:aws: s3::: < s3 bucket > / *”),“條件”:{“NotIpAddressIfExists”:{“aws: SourceIp”:[“< CONTROL-PLANE-NAT-IP >”,“< CORPORATE-VPN-IP >”]},“StringNotEqualsIfExists”:{“aws: sourceVpce”:“< VPCE-ID >”}}}